A bevezetőben említettük, hogy egy valószínűségi változó különböző függvényeinek várható értéke révén a valószínűségi változó sok fontos tulajdonságát jellemezhetjük. Ebben a fejezetben olyan várható értékeket fogunk vizsgálni, melyekkel két valószínűségi változó egymáshoz való viszonyát írjuk majd le. Ez a viszony rendkívül fontos mind a valószínűségszámításban, mint a statisztikában.

Mint általában, a kiindulási pontunk most is egy eseménytér és azon egy valószínűségi mértékkel ellátott véletlen kísérlet. Tegyük fel, hogy és valós értékű valószínűségi változók, melyeknek várható értékeik , szórásnégyzeteik pedig , (ezekről feltesszük, hogy végesek). Ekkor és kovarianciája:

és (feltéve, hogy a szórásnégyzetek pozitívak), és korrelációja:

A korreláció a kovariancia skálázott változata. Vegyük észre, hogy a két mennyiségnek mindig azonos az előjele (pozitív, negatív, vagy 0). Ha az előjel pozitív, azt mondjuk, hogy a változók pozitívan korreláltak, ha negatív, negatívan korreláltak, ha 0, korrelálatlanok. Vegyük észre továbbá, hogy a korreláció dimenzió nélküli mérőszám, hisz a számláló és a nevező mértékegysége megegyezik.

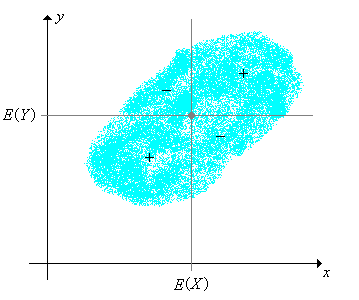

Ahogy a neve sugallhatja, a kovariancia és a korreláció a valószínűségi változók közötti függőséget méri. Célunk most ezt a függőséget jól megérteni. Vegyük észre, hogy az , együttes eloszlásának középpontja, továbbá az ezen a ponton átmenő vízszintes és függőleges egyenes -et négy részre osztja. A függvény ezek közül a síknegyedek közül az elsőn és a harmadikon pozitív, a másodikon és a negyediken negatív.

A következő feladatok a kovariancia alapvető tulajdonságaira világítanak rá. Megoldásukhoz lényeges tudni, hogy egy valószínűségi változó lineáris függvényének várható értékét hogyan számítjuk ki. A kovariancia más érdekes tulajdonságait a legjobb lineáris becslőről szóló részben fogjuk megismerni.

Igazoljuk, hogy .

Az 1. feladat alapján és akkor és csak akkor korrelálatlanok, ha . Speciálisan, ha és függetlenek, akkor korrelálatlanok. Az állítás megfordítása viszont nem igaz, ahogy azt a következő feladat is demonstrálja. (Még több ilyen példát fogunk látni a számolási feladatoknál.)

Tegyük fel, hogy egyenletes eloszlású az intervallumon, ahol és Igazoljuk, hogy és korrelálatlanok, miközben az függvénye (azaz nemcsak hogy nem függetlenek, de a lehető legszorosabb köztük a függőség).

Igazoljuk, hogy .

Igazoljuk, hogy . Tehát a szórásnégyzet a kovariancia speciális esete.

Igazoljuk, hogy .

Igazoljuk, hogy

Tehát ha a második változót fixen hagyjuk, a kovariancia lineáris az első változójában. A szimmetria miatt ez fordítva is igaz: ha az első változót fixen hagyjuk, lineáris a második változójában. Tehát a kovariancia operátor bi-lineáris. Ennek a tulajdonságnak az általános megfogalmazása a következő feladat:

Tegyük fel, hogy és valós értékű valószínűségi változók sorozatai. Igazoljuk, hogy

Igazoljuk, hogy és korrelációja megegyezik a standardizáltjaik korrelációjával:

Belátjuk, hogy valószínűségi változók összegének szórásnégyzete épp a páronként vett kovarianciák összege. Ez azért is fontos eredmény, hisz sok nevezetes eloszlást felírhatunk egyszerűbb eloszlású valószínűségi változók összegeként (lásd például a binomiális eloszlást, vagy a hipergeometriai eloszlást).

Tegyük fel, hogy valós értékű valószínűségi változók sorozata. A 3. feladat, 4. feladat és a 6. feladat segítségével igazoljuk, hogy

Vegyük észre, hogy az összeg varianciája lehet kisebb, nagyobb, vagy egyenlő az varianciák összegével. A 9. feladat speciális eseteként, ha , akkor

Vegyük észre, hogy az előző feladat alkalmazható arra a speciális esetre, amikor a valószínűségi változók páronként függetlenek.

Legyenek és valós értékű valószínűségi változók. Igazoljuk, hogy .

Tegyük fel, hogy és valós értékű valószínűségi változók, továbbá . Igazoljuk, hogy és korrelálatlanok.

A következő feladatokban legyen független, azonos eloszlású valós értékű valószínűségi változók sorozata, melyeknek közös várható értékük szórásuk . (Azaz, a változók egy közös eloszlásból származó véletlen mintát alkotnak).

Legyen . Igazoljuk, hogy

Legyen . Azaz a mintaátlag. Igazoljuk, hogy

Az előző feladat (b) része értelmében amint négyzetes középben. A (c) rész értelmében pedig amint valószínűségben. Ez a két állítás a valószínűségszámítás egyik legfontosabb tételének, a nagy számok gyenge törvényének a két alakja.

Legyen , azaz standardizáltja. Igazoljuk, hogy

A centrális határeloszlás-tétel, a valószínűségszámítás másik fontos alaptétele azt állítja, hogy eloszlása, amint tart a normális eloszláshoz.

Legyenek és egy kísérlethez tartozó események. Ekkor és kovarianciája és korrelációja definíció szerint az indikátor valószínűségi változóik kovarianciája, illetve korrelációja.

Igazoljuk, hogy

Speciálisan és pozitívan korreláltak/negatívan korreláltak/függetlenek (a feltételes valószínűségről szóló fejezetben lévő definíció értelmében) pontosan akkor, ha illetve indikátor valószínűségi változóik pozitívan korreláltak/negatívan korreláltak/korrelálatlanok.

Igazoljuk, hogy

Tegyük fel, hogy Igazoljuk, hogy

Vajon melyik lineáris függvénye van a legközelebb -hoz abban az értelemben, hogy mikor a legkisebb a négyzetes hiba? Akkor rendkívül fontos ez a kérdés, ha az valószínűségi változó megfigyelhető (úgynevezett magyarázó változó), az viszont nem (úgynevezett magyarázott változó). A lineáris függvényünkkel ez esetben a megfigyelt értékből becsüljük értékét. A megfelelő lineáris függvény megtalálása során megfigyelhetjük, hogy a kovariancia és a korreláció valójában az és közötti lineáris kapcsolatot méri. A triviális eseteket zárjuk ki, azaz tegyük fel, hogy és , vagyis a valószínűségi változóink valóban függnek a véletlentől.

Jelölje az átlagos négyzetes hibát, amikor az lineáris kifejezéssel közelítjük értékét. (Az MSE a mean square error angol kifejezés rövidítése.) Ez az és a paraméterek függvénye:

Igazoljuk, hogy

Igazoljuk, hogy akkor minimális, ha

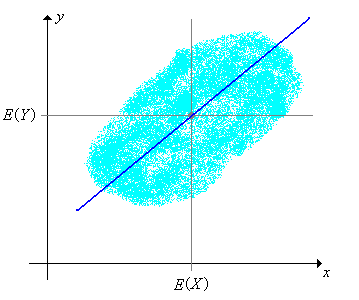

Tehát legjobb lineáris becslője ismeretében az valószínűségi változó, ahol

Igazoljuk, hogy az MSE átlagos négyzetes hibafüggvény minimuma

Az előző feladatot felhasználva igazoljuk a következő fontos tulajdonságokat:

Az előző feladatok világosan mutatják, hogy és az és közötti lineáris kapcsolatot mérik.

Nyilván legjobb konstans becslése, azaz, amikor minimális az átlagos négyzetes hiba, épp és ekkor az átlagos négyzetes hiba értéke . Tehát az szórásnégyzete és a 21. feladat-ban kapott legkisebb négyzetes hiba közti különbség az a mennyiség, amennyivel csökken az bizonytalansága, ha a becslőnkben megjelenhet egy -ben lineáris tag.

Igazoljuk, hogy A szórásnégyzet relatív csökkenése , ezért ezt a mennyiséget úgy hívják, hogy meghatározottsági együttható.

Legyen

A fenti jelöléssel az függvényt -re vonatkozó lineáris regressziós függvényének nevezzük, a függvény grafikonja pedig a regressziós egyenes. Vegyük észre, hogy a regressziós egyenes illeszkedik az pontra, azaz az együttes eloszlás középpontjára.

Igazoljuk, hogy .

A magyarázó és a magyarázott változók szerepe triviálisan nem cserélhető fel, erre a jelenségre világít rá a következő feladat.

Igazoljuk, hogy -re vonatkozó regressziós egyenese és -ra vonatkozó regressziós egyenese általában nem esik egybe, kivéve a triviális esetet, azaz amikor a két változó maximálisan korrelált. A meghatározottsági együttható viszont független attól, hogy melyik változó a függő és melyik a független.

Legyenek és véletlen események, továbbá és . Igazoljuk, hogy

A legjobb lineáris becslő még annál is hasznosabb, mint amilyennek az eddig elmondottak alapján tűnik. Ugyanis nemcsak az eredeti valószínűségi változókra, hanem azok transzformáltjaira is alkalmazhatjuk az eddigieket. Tegyük fel, hogy és , illetve értékű valószínűségi változók. Legyenek továbbá és valós értékű függvények, melyek értelmezési tartománya illetve . Ekkor meghatározhatjuk -et, azaz azon lineáris függvényét, amely a legközelebb van -hoz olyan értelemben, hogy minimális az átlagos négyzetes hiba. Természetesen az eddigi eredményeink alkalmazhatók arra az esetre is, amikor helyett , helyett szerepel.

Tegyük fel, hogy egy valós értékű valószínűségi változó, pedig konstans. Igazoljuk, hogy

Az előbb tárgyalt kérdéskör több irányban is általánosítható:

Legyen az pár egyenletes eloszlású az halmazon. Határozzuk meg -t és -t, és döntsük el, hogy függetlenek-e a változók a következő esetekben:

A kétdimenziós egyenletes eloszlás kísérletében válasszuk ki az alábbi halmazokat. Minden halmazra szimuláljunk 2000 kísérletet (frissítsük az ábrát minden 10. után), és figyeljük meg, hogyan változik a korreláció értéke és a pontfelhő alakja. Hasonlítsuk ezt össze az előző feladat eredményével.

Tegyük fel, hogy egyenletes eloszlású a intervallumon, és ha , akkor egyenletes eloszlású -en.

Egy hagyományos kocka alatt hat oldalú dobókockát értünk. Az igazságos kocka olyan, hogy ha feldobjuk, minden oldalára azonos valószínűséggel esik. Az egy-hat irányban lapos kocka egy hagyományos kocka, ami feldobás után az 1 és 6 értékeket , a 2, 3, 4 és 5 értékeket valószínűséggel mutatja.

Két igazságos kockát feldobtunk, a dobott értékeket az pár jelöli. Legyen a dobott számok összege, a kisebbik dobott szám, a nagyobbik dobott szám. Határozzuk meg a következő valószínűségi változó párok kovarianciáját és korrelációját:

Tegyük fel, hogy most db igazságos kockát dobtunk fel. Határozzuk meg a következő valószínűségi változók várható értékét és varianciáját:

A kockadobálós kísérletben válasszuk ki a következő valószínűségi változókat. Minden esetben növeljük a kockák számát, és figyeljük meg, hogyan változik a várható értéket és a szórást jelölő intervallum. paraméterválasztással szimuláljunk 1000 kísérletet (frissítsük az ábrát minden tizedik után), és figyeljük meg, hogyan konvergálnak az empirikus momentumok a valódi momentumokhoz.

Oldjuk meg a 32. feladatot egy-hat irányban lapos kockával.

Oldjuk meg a 33. feladatot egy-hat irányban lapos kockával.

Két igazságos kockát feldobtunk, a dobott értékeket az pár jelöli. Legyen a dobott számok összege, a nagyobbik dobott szám, a kisebbik dobott szám. Határozzuk meg a következőket:

A Bernoulli kísérletek folyamata egy független, azonos eloszlású indikátor valószínűségi változókból álló sorozat. Megbízhatóság-elméleti kifejezéssel élve jelöli az -edik kísérlet eredményét, ahol 1-et írunk, ha sikeres volt a kísérlet és 0-t, ha sikertelen. A siker valószínűsége ez a folyamat paramétere. Nevét James Bernoulli-ról kapta. A folyamat részletes tárgyalása a Bernoulli kísérletek fejezetben található.

Az első kísérletből a sikeresek száma . Ez a valószínűségi változó és paraméterű binomiális eloszlású, melynek valószínűségi súlyfüggvénye

Igazoljuk, hogy

A binomiális érmedobás kísérletben válasszuk a fejek számát. Változtassuk az és paraméter értékeit, és figyeljük meg, hogyan változik a várható értéket és a szórást jelölő intervallum. Néhány és paraméterpárral szimuláljunk 1000 kísérletet (frissítsük az ábrát minden tizedik után), és figyeljük meg, hogyan konvergál az empirikus várható érték és szórás a valódi várható értékhez és szóráshoz.

Az első kísérlet során a sikeresek aránya . Ezt a valószínűségi változót nevezik a paraméter statisztikai becslőjének.

Igazoljuk, hogy

A binomiális érmedobás kísérletében válasszuk a fejek arányát. Változtassuk az és paraméterértékeket, és figyeljük meg, hogyan változik a várható értéket és a szórást jelölő intervallum. Néhány és paraméterpárral szimuláljunk 1000 kísérletet (frissítsük az ábrát minden tizedik után), és figyeljük meg, hogyan konvergál az empirikus várható érték és szórás a valódi várható értékhez és szóráshoz.

Tegyük fel, hogy egy populáció egyedből áll, ezek közül darab 1-es típusú, darab pedig 0-ás típusú. Visszatevés nélkül kiválasztunk véletlen egyedet. Legyen az -edik kiválasztott egyed típusa. Ekkor tudjuk, hogy azonos eloszlású valószínűségi változók, melyek azonban nem függetlenek. Valójában ez a valószínűségi változó sorozat felcserélhető, tehát például minden -re és minden különböző -re és -re.

Jelölje a mintában előforduló 1-es típusú egyedek számát, azaz Ekkor ez a valószínűségi változó hipergeometriai eloszlású, és valószínűségi súlyfüggvénye:

Igazoljuk, hogy különböző -re és -re

Vegyük észre, hogy az az esemény, hogy az -edik húzásra 1-es típusú egyedet választunk, illetve hogy a -edik húzásra 1-es típusú egyedet választunk, negatívan korreláltak, de a korreláció nem függ az 1-es típusú egyedek számától, csak a populáció létszámától. Vegyük továbbá észre, hogy a korreláció maximális, ha . Meg tudjuk ezt intuitívan magyarázni?

Igazoljuk, hogy

A golyók és urnák kísérletben válasszunk visszatevés nélküli mintavételt. Változtassuk , és értékét, és figyeljük meg, hogyan változik súlyfüggvény alakja, valamint a várható értéket és a szórást jelölő intervallum. Néhány fix paraméterválasztással szimuláljunk 1000 kísérletet (frissítsük az ábrát minden tizedik után), és figyeljük meg, hogyan konvergál az empirikus várható érték és szórás a valódi várható értékhez és szóráshoz.

Legyen az valószínűségi változó pár együttes sűrűségfüggvénye .

Legyen az valószínűségi változó pár együttes sűrűségfüggvénye .

Legyen az valószínűségi változó pár együttes sűrűségfüggvénye .

Legyen az valószínűségi változó pár együttes sűrűségfüggvénye .

Legyen az valószínűségi változó pár együttes sűrűségfüggvénye .

Legyen az valószínűségi változó pár együttes sűrűségfüggvénye .

A kovariancia a vektorterek elméletében a skaláris, vagy belső szorzatnak felel meg. Hasznos, ha megértjük ezt a definíciót is, ugyanis ha egy másik szemszögből is megvizsgáljuk ugyanazt a fogalmat, akkor jobban megérthetjük a jelenségeket.

Ebben a fejezetben a vektortér az olyan valószínűségi mezőn értelmezett valós értékű valószínűségi változókból áll, melyeknek véges a második momentumuk. Két valószínűségi változót ekvivalensnek nevezünk, ha 1 valószínűséggel megegyeznek. Két ilyen valószínűségi változóhoz rendeljük ugyanazt a vektort, így precízen a vektorterünk a fenti ekvivalencia reláció szerinti ekvivalencia osztályokból áll. Az összeadás legyen a valószínűségi változók, mint függvények összeadása, a skalárral való szorzás pedig a valószínűségi változó, mint függvény, adott (determinisztikus) számmal való szorzása.

Ha és -beli valószínűségi változók, akkor definiálhatjuk a belső szorzatukat (vagy skaláris szorzatukat) a következő módon:

A következő feladatban a már korábban bizonyított kovariancia alaptulajdonságainak megfelelő állításokat bizonyíthatjuk be, és egyúttal azt is belátjuk, hogy a fenti definíció valóban egy belső szorzat.

Igazoljuk, hogy

Ezzel a belső szorzattal könnyen definiálható a kovariancia és a korreláció. Két valószínűségi változókovarianciája ugyanis nem más, mint a centrált változatuk belső szorzata, korrelációja pedig épp a standardizáltjuk belső szorzata.

Igazoljuk, hogy

A fenti belső szorzatból származó norma épp az átlagos négyzetes távolság. Egyedül a 2-norma származik belső szorzatból az összes -norma közül, ezért is olyan fontos az átlagos négyzetes távolság mind a valószínűségszámításban, mind a statisztikában.

Igazoljuk, hogy .

Legyenek és -beli valószínűségi változók.

Igazoljuk, hogy a következő halmaz altere. Ezt a halmazt úgy is hívják, hogy az és az 1 elemek által generált altér:

Igazoljuk, hogy ismeretében legjobb lineáris becslője nem más, mint -nak a altérre vett projekciója (vagy vetítése). Vagyis lássuk be, hogy az egyetlen olyan valószínűségi változó, hogy merőleges -re. Ezt úgy láthatjuk be, hogy olyan vektort keresünk, amely kielégíti a következő két egyenletet:

A következő feladatban a Hölder egyenlőtlenséget látjuk be (amely nevét Otto Hölder-ről kapta).

Tegyük fel, hogy , , és . Az alábbi lépéseket követve lássuk be, hogy :

Az előző feladatban szereplő és értékeket konjugált exponenseknek nevezik. Ha a speciális esetet tekintjük, visszakapjuk a Cauchy-Schwarz egyenlőtlenséget (nevét Augustin Cauchy-ről és Karl Schwarz-ról kapta). Ez utóbbi ekvivalens a 22. feladatban bizonyított egyenlőtlenséggel.

Legyen az valószínűségi változó pár együttes sűrűségfüggvénye . Igazoljuk a Hölder egyenlőtlenséget a következő esetekben:

Tegyük fel, hogy és konjugált exponensek.

A következő feladat a 11. feladat analógja vektorterek esetén.

Igazoljuk a paralelogramma szabályt:

A következő feladat a 10. feladat analógja vektorterek esetén.

Bizonyítsuk be a Pitagorasz tételt (amely a nevét természetesen Pythagoras-ról kapta): ha egy olyan valós értékű valószínűségi változókból álló sorozat, hogy ha akkor